AIコンピュータの内部:なぜ現代のAIシステムはこれほど大量のメモリを消費するのか

カバーを開けたときに見える、AIサーバーの本当の姿

現在、AIが「メモリを使いすぎている」という話題があふれています。価格は上昇し、供給は逼迫し、需要は爆発的だと言われています。おそらく、すでに何度も目にしているでしょう。

しかし、ほとんどの記事は最も重要な点を見落としています。それは、AIコンピュータが物理的にどのような姿をしているのか、そしてなぜ最初からこれほど多くのメモリを必要とするのか、という点です。抽象的なチャートや市場予測ではなく、実際にイメージできる形で理解することが重要です。ひとつのAIシステムが実際にどれほどのリソースを消費しているかを理解すれば、残りの話は大げさではなく、必然に聞こえてきます。

私は最近、データセンターとはまったく関係のない場所で、この話を説明する機会がありました。子どもの学校で行われた「保護者参観日」で教室に立っていたとき、数人の生徒がAIについて質問してきたのです。チャットボットの話ではありません。もっと素朴で本質的な質問でした。コンピュータはどんな形をしているのか。データはどこへ行くのか。なぜ皆が「メモリ」の話ばかりするのか。

そこで私は、まず基本から話しました。家庭で使う普通のコンピュータを想像してもらったのです。計算を行うプロセッサがあり、今処理している内容を保持するメモリがあり、後で使うために保存するストレージがあります。宿題、写真、ゲーム。すべてに置き場所があります。

次に、AIも同じくコンピュータであることを説明しました。ただし、AIは小さな作業を一つずつ処理するわけではありません。膨大な量のデータに対して、膨大な計算を何度も繰り返し、パターンを比較し、重みを調整し、チェックポイントを保存し続けます。その処理速度が非常に速いため、ストレージ待ちが最大の敵になります。

だからこそ、メモリが主役になるのです。流行だからではありません。十分なメモリと高速なストレージがなければ、GPUはただ待つだけになってしまいます。それは、道が狭すぎて走れないのに、レーシングカーを買うようなものです。

AIサーバーは、単なるデスクトップタワーではありません。極限まで高密度に詰め込まれたワークステーションに近い存在です。現在一般的な学習用サーバーには8基のGPUが搭載されており、それぞれのGPUには計算に追従するための超高速メモリが備えられています。さらに、GPUに十分なデータを供給するための大容量システムメモリと、データセットの配置や中間結果の書き込みを行うためのNVMe SSDが筐体内に搭載されています。

こうしたマシンの実際の部品構成を見ると、その規模は一目瞭然です。数百ギガバイトのGPUメモリ、場合によっては0.5テラバイトから数テラバイトのシステムRAM、そして数十テラバイトのNVMe SSDストレージが、1台のサーバーに収められています。ネットワーク越しでも、共有SANでもありません。1つの筐体の中です。

多くの場合、このあたりで話を聞いている人は静かになります。規模の大きさが実感できるからです。1台のサーバーが、一般家庭が一生で所有する以上のフラッシュストレージを搭載していることも珍しくありません。そしてAIは、1台ずつ追加して終わりという形ではスケールしません。大規模モデルの学習はチーム戦であり、数十台、数百台単位で同時に追加されます。

では、1台のAIサーバーが20〜30テラバイトのフラッシュを静かに消費するとしたら、100台導入した場合はどうなるでしょうか。一度の構築で、ペタバイト級のNANDフラッシュが消費されることになります。そこには、共有ストレージ、レプリケーション、バックアップ、ログ管理、そして「前四半期よりも高速に」という要求による追加投資は含まれていません。

この時点で、メモリ不足の話は誇張ではなく、単純な計算の結果だと分かります。メモリ工場は一夜にして建てられるものではありません。フラッシュやDRAMの計画、建設、認証、量産には何年もかかります。メモリ価格の変動が話題になっていても、データセンター規模の需要が現れた瞬間に、供給制約が消えるわけではありません。

そして次の段階が、ラックスケールのシステムです。各サーバーを個別のマシンとして扱うのではなく、ベンダーはラック全体を1台のコンピュータのように設計します。1ラックに数十基のGPU、大規模なメモリプール、隙間なく並べられたSSD。距離はメートルではなくインチ単位で測られます。それほど速度が重要なのです。

ここまで来ると、「1台のコンピュータにどれだけのメモリが必要か」という問いは意味を失います。代わりに、「1ラックにどれだけのメモリが必要か」が問題になります。これが、消費者向け電子機器が圧迫される理由です。消費者が急にスマートフォンを倍買い始めたからではなく、まったく異なるスケールの需要を持つ新しい買い手が現れ、データセンター単位で購入するからです。

ストレージの観点から見ると、これまで当たり前とされてきたフラッシュの前提が崩れ始めている理由も分かります。AIワークロードが需要を支配すると、MLCとTLC NANDの違いは学術的な話ではなくなり、可用性、耐久性、割り当て判断に直接影響を及ぼします。

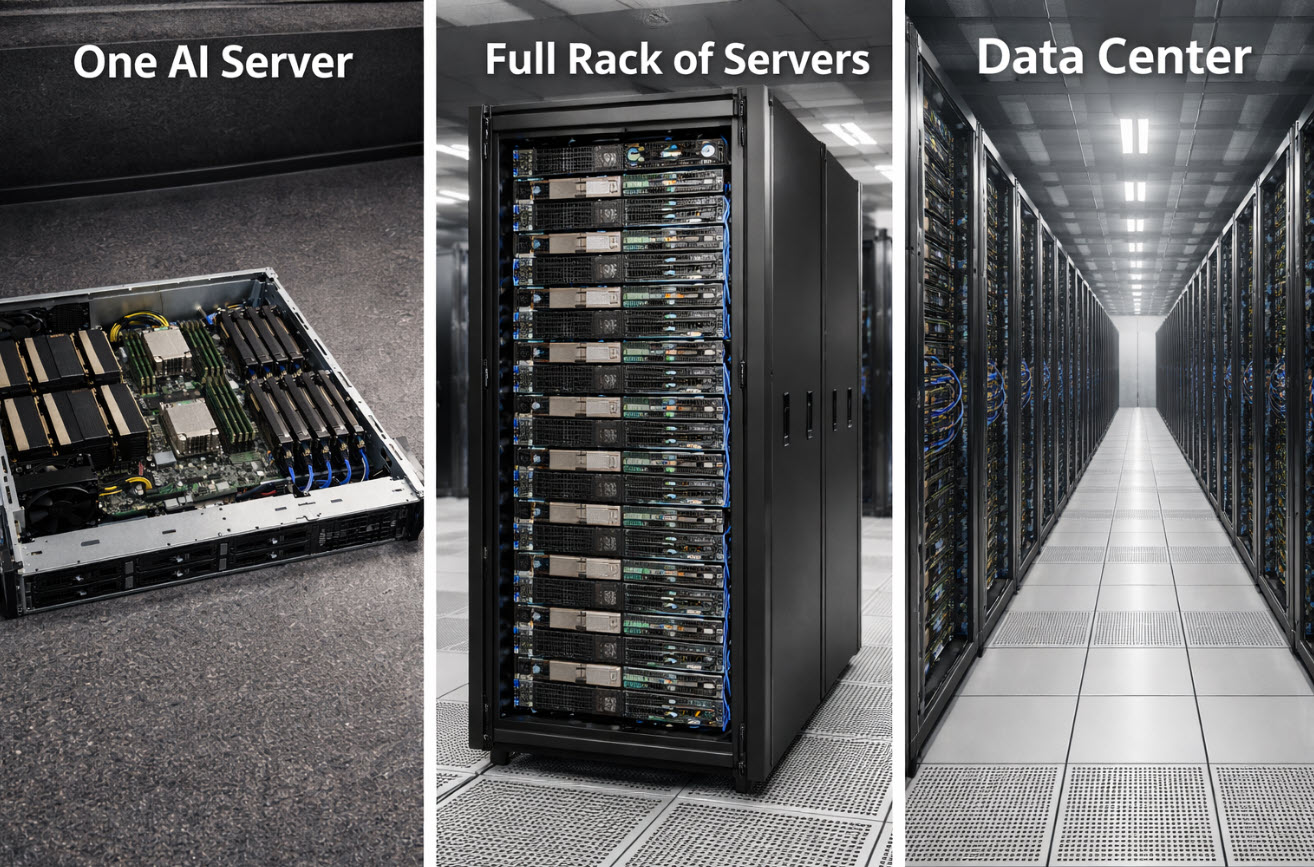

子どもたちはサプライチェーンの講義を必要としていませんでした。必要だったのは、全体像だけです。1台が列になり、列がラックになり、ラックが部屋になり、部屋が建物になります。AIを魔法ではなくインフラとして捉えた瞬間、メモリの話は物理的で、機械的で、予測可能なものになります。

そして、それこそが本質です。これは謎めいた不足ではありません。構築に何年もかかる供給能力と、トラック数台分のサーバーという形で一夜にして現れる需要との、避けられない衝突なのです。

要するに、AIは単に以前より多くのメモリを使っているだけではありません。「通常」とされるメモリ量そのものを再定義しているのです。

この記事の作成方法

著者プロフィールは下記参照 — USBストレージシステムおよび複製の専門家

本記事は、構成および表現の下書きにAIを活用し、その後、人間の著者が内容を精査・編集・最終化することで、分かりやすさ、正確性、実務的な関連性を高めています。

画像に関する注記

本記事冒頭の画像は、説明目的で人工知能を用いて生成されたものです。実在する環境を撮影した写真ではありません。